Jun 11, 2024 | 22 min read

Operadores#

\( \newcommand{\bra}[1]{\langle #1|} \) \( \newcommand{\ket}[1]{|#1\rangle} \) \( \newcommand{\braket}[2]{\langle #1|#2\rangle} \) \( \newcommand{\ketbra}[2]{| #1\rangle\mkern-1.4mu\langle #2|} \) \( \newcommand{\tr}{{\rm tr}} \) \( \newcommand{\i}{{\color{blue} i}} \) \( \newcommand{\Hil}{{\cal H}} \) \( \newcommand{\V}{{\cal V}} \) \( \newcommand{\Lin}{\hbox{Lin}} \) \( \newcommand{\boldsig}{\boldsymbol{\sigma}} \)

Show code cell source

%run ../../macro_tQ.py

import sys

sys.path.append('../../')

import macro_tQ as tQ

import numpy as np

import scipy.linalg as la

from IPython.display import display,Markdown,Latex

import matplotlib.pyplot as plt

from qiskit.visualization import array_to_latex

from IPython.display import display, Latex

Operador#

En un espacio vectorial, además de los vectores, es necesario entender la manera en que estos se pueden transformar entre sí

Definición: Operador lineal

Un operador lineal es una aplicación \(A:\Hil \to \Hil\) que transforma un vector en otro

de forma lineal.

La linealidad se refiere a la siguiente propiedad:

Ejemplo

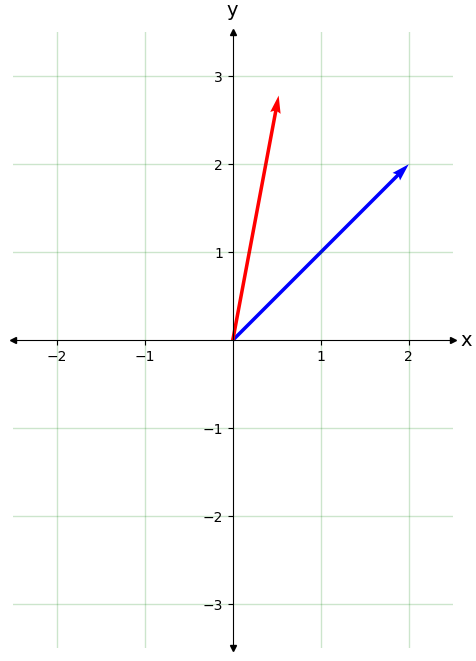

Un operador fácil de visualizar es el operador de rotación en un plano. Dado un ángulo \(\theta \in (0,2\pi)\) el operador \(A = R(\theta)\) gira cualquier vector un ángulo \(\theta\) en el sentido antihorario

Un vector en el plano \({\bf u} = (u_1,u_2)\) es equivalente al número complejo \(u = u_1 + i u_2\) en el plano complejo \(V = {\mathbb C}\).

Escrito en polares, \(u=|u|e^{i\phi}\), sabemos que una rotación de ángulo \(\theta\) es equivalente a añadirle dicho ángulo a la fase

Por tanto, para rotar un número complejo un ángulo \(\theta\) basta con multiplicarlo por la fase \(e^{i\theta}\), que se corresponde con el operador \(R(\theta)\) en el espacio vectorial \(V = \mathbb{C}\). La propiedad fundamental de una rotación es la de mantener invariante el módulo \(|v| = |u|\).

'''ángulo que queremos rotar'''

theta=0.6

'''vector a rotar'''

u1=2.

u2=2.

'Función que rota un vector tratándolo como un número complejo'

def R(u1,u2,theta):

u = u1 + u2*1j

v = u*np.exp(1j*theta) # u rotado un angulo theta

return v.real,v.imag

'''v1 y v2 a partir de u1, u2 y theta'''

v1,v2 = R(u1,u2,theta)

''' Representación en el plano complejo '''

v = v1**2+v2**2

tQ.plot_2D_plane(left=-int(abs(v1))-2,right=int(abs(v1))+2,up=int(abs(v2))+1,down=-int(abs(v2))-1)

tQ.draw_vector(u1,u1,vcolor='b')

tQ.draw_vector(v1,v2,vcolor='r')

Matriz de un operador#

Dada una base \(\{\ket{i}\}\) con \(i=1,...,N\), podemos asociar a cada operador \(A\), una matriz \(A_{ij}\). Veamos por qué: escribamos los vectores \(\ket{u}\) y \(\ket{v} \) en la base \(\{\ket{i}\}\)

El hecho de que \(\ket{v} = A\ket{u}\) donde \(A\) es un operador lineal quiere decir que existe una matriz

que relaciona las componentes de ambos vectores

o, lo que es igual $\( v_i = \sum_{j=1}^N A_{ij} u_j \, \)$

Ejemplo

Continuando con el ejemplo del operador de rotación en un plano, hemos visto que las componentes de \(u = u_1 + i u_2\) y las de \(R(\theta)u = v = v_1 + i v_2\) se obtienen mediante la multiplicación por una fase pura

Vamos a desarrollar cada miembro en cartesianas, separando las partes real e imaginaria

es decir las coordenadas del vector origen y el vector rotado imagen se relacionan en la forma

que podemos expresar en forma matricial

Base de Operadores#

Hay una clase de operadores muy simples que se puede formar a partir de dos vectores. No son los operadores e más generales, pero servirán como base para expresar cualquier operador lineal

Producto externo#

Dependiendo del orden en que los compongamos, \(~\braket{u}{v}~\) ó \(~\ketbra{v}{u}~\), el resultado es muy distinto

El producto interno, o producto escalar es un número complejo

El producto externo es un operador

Para comprender por qué es un operador, observamos que dicha expresión aplicada a un vector \(\ket{w}\) da otro,

Notar

El orden en que escribimos las cosas es relevante o no según los casos. Por ejemplo \(\braket{u}{v}\) y \(\ketbra{v}{u}\) son objetos radicalmente distintos: el primero es un número y el segundo es un operador. En cambio \(\ket{v} \lambda = \lambda \ket{v}\), así como \(\bra{u}\lambda = \lambda\bra{u}\), es decir, los números complejos y los \(kets\) o \(bras\) pueden escribirse en cualquier orden (decimos que conmutan).

La acción del operador \(A = \ket{v}\bra{u}\) es muy fácil de verbalizar:

el operador \(A\) toma un vector \(\ket{w}\) y lo convierte en otro paralelo a \(\ket{v}\) de módulo proporcional a \(\lambda=\braket{u}{w}\)

si la proyección es nula \(\lambda=0\), el operador aniquila, es decir, su imagen es el elemento neutro

La diferencia entre el producto interno \(a=\braket{u}{v}\) y el externo \(A=\ketbra{u}{v}\) tiene su reflejo en una base expresando ambos vectores, \(\ket{u} = \sum_i u_i\ket{i}\) y \(\ket{v} = \sum_j v_j \ket{j}\), en componentes en una base ortonormal

el número complejo \(a\) es el producto escalar

la matriz \(A_{ij}\) representa el operador \(A\) en la base \(\{\ket{i}\}\)

Base canónica de operadores#

Consideremos el producto externo de dos elementos de la base ortonormal \(\ketbra{i}{j}\)

La acción sobre otro vector de la base, \(\ket{k}\), es

La matriz asociada tiene sólo un 1 en el elemento \((ij)\) y cero en todos los demás. Por ejemplo, supongamos que \(N=4\)

Teorema:

Los operadores \(\ketbra{i}{j}\) forman una base para cualquier operador lineal \(A\), donde las componentes son los elementos de matriz \(A_{ij}\)

>>Demostración

Verifiquemos que actúa de la forma correcta

Elementos de matriz#

El producto escalar muestra ahora su utilidad de nuevo. De la misma manera que obteníamos las componentes de un vector proyectando sobre un elemento de la base

ahora podemos obtener los elementos de matriz de un operador \(A\) a partir del siguiente sandwich

Ejercicio

comprueba la consistencia de las expresiones \(~A = \sum_{i,j=1}^N A_{ij} \ketbra{i}{j} \) y \(~A_{ij} = \bra{i} A \ket{j}\)

Resumen

Dada una base \(\{\ket{i}\}\) podemos expresar un operador mediante una matriz \(A_{ij}\). La relación concreta es

como operador \(\to ~ A = \sum_{ij} A_{ij}\ketbra{i}{j}\)

como elemento de matriz \(\to ~ A_{ij} = \bra{i}A\ket{j}\)

Relación de completitud#

La acción del operador identidad es

En particular, sobre todo elemento de la base \(I\ket{i} = \ket{i}\). En otras palabras, el operador identidad \(I\) tiene por matriz \(I_{ij}=\delta_{ij}={\rm diagonal}\, (1,1,...,1)\) con lo que

Esta expresión se conoce también como relación de completitud o, también, relación de cierre y se utiliza muy frecuentemente.

Notar

La relación de completitud es una propiedad de cualquier base. Dicho de otro modo, si \(\{\ket{e_i}\}\) y \(\{\ket{\tilde e_i}\}\) ambas son bases, entonces \(I\ket{e_i} = \ket{e_ i}\) y \(I\ket{\tilde e_j} = \ket{\tilde e_j}\), entonces \(+1\) es el único autovalor de \(I\) en cualquier base, y la descomposición espectral da

Cambios de base#

La relación de cierre siempre se puede insertar en cualquier momento del cálculo. Se utiliza con frecuencia para efectuar cambios de base. Efectivamente insertando la identidad delante de un elemento de la base

donde la matrices de cambio son

Notar que la matriz inversa es igual a la adjunta

Esto ocurre si y sólo si las bases \(\{\ket{e_i}\}\) y \(\{\ket{\tilde e_i}\}\) son ambas ortonormales

De la misma manera podemos relacionar las componentes de un vector en ambas bases

Las componentes son, en cada base

Insertando la identidad

Es decir

Igualmente podemos hallar la regla de transformación de las matrices asociadas a un operador en dos bases distintas

Ejercicio

La matriz \(\begin{pmatrix} 0 & -i \\ i & 0\end{pmatrix}\) representa un operador \(\sigma_y\) en la base \(\{\ket{0},\ket{1}\}\). Escribe \(\sigma_y\) en la base \(\{\ket{\!+\!i}= \frac{1}{\sqrt{2}}(\ket{0}+i \ket{1}),\ket{\!-\!i}= \frac{1}{\sqrt{2}}(\ket{0}-i \ket{1})\}\)

Ejercicio

Escribe en python una función \(basis\_change\) que reciba una matriz \(U_{ij}\) de cambio de base \(\ket{\tilde e_j} = \sum_i{U_{ij}}\ket{e_i}\), la componentes \(v_i\) de un vector, ó \(A_{ij}\) de un operador, y devuelva las componentes \(\tilde v_i~\) ó \(~\tilde A_{ij}\) en la nueva base.

El Espacio Vectorial \(\Lin(\Hil)\)#

El conjunto de todos los operadores lineales sobre un espacio vectorial \(\Hil\) tiene, de forma natural, una estructura de espacio vectorial que denominamos \(\Lin(\Hil)\)

Dados dos operadores, \(A\) y \(B\) tanto la suma \(C = A+B\) como la multiplicación por un número complejo \(D=\lambda A\) son nuevos operadores definidos por su acción sobre un vector cualquiera \(\ket{v}\in \Hil\)

Si \(\Hil\) tiene dimensión \(N\), un operador general \(A\in \Lin(\Hil)\) se especifica mediante una matriz de \(N^2\) números complejos \(\Rightarrow A = A_{ij}\ket{e_i}\bra{e_j}\). En otras palabras: la dimension (compleja) del espacio de operadores lineales es \( {\rm dim}_{\bf C}(\Lin(\Hil)) = N^2\, \)

Operador Adjunto#

La conjugación adjunta se puede extender a \({\rm Lin}(\Hil)\)

y hay dos reglas más que permiten aplicar \(\dagger\) a sumas y productos de objetos \(a \in\{z,\ket{u},A\}\)

linealidad \(( a + b)^\dagger = a^\dagger + b^\dagger \)

trasposición \((ab)^\dagger = b^\dagger a^\dagger\) (sólo relevante cuando \(a\) y \(b\) no conmuten)

Por ejemplo $\( \big( A(z\ket{u})\big)^\dagger = z^*\bra{u}A^\dagger \)$

Matriz adjunta#

Estas reglas nos permiten obtener el adjunto de un operador

donde en la última ecuación hemos intercambiado los nombres de los índices \(i\leftrightarrow j\). Vemos que la matriz que representa \(A^\dagger\) es la matriz adjunta de \(A_{ij}\), es decir, la traspuesta y conjugada

donde \(^\dagger\) significa el adjunto de un operador a la izquierda, y de una matriz a la derecha.

Traza#

Definición:

La traza de un operador \(A\) se define como la suma de sus elementos de matriz diagonales en cualquier base

Para ser consistente esta definición es necesario probar que no importa la base utilizada

Lema:

La traza de un operador es independiente de la base en la que se calcule

Prueba

La traza posee dos propiedades importantes

linealidad :

ciclicidad: la traza es invariante bajo permutaciones cíclicas de los operadores en su argumento. Por ejemplo, para tres operadores \(A, B\) y \(C\)

aniquila conmutadores: para un producto de dos operadores, el anterior resultado implica que la traza de un conmutador es cero. Dicho de otra forma

Notar

sea el operador \(A = \ketbra{u}{v}\) entonces \( \tr \left(\rule{0mm}{5mm}\ketbra{u}{v}\right) = \braket{v}{u}\). Efectivamente

Ejercicio

demuestra la ciclicidad de la traza

\(\Lin(\Hil)\) como un espacio de Hilbert#

Para transformar el espacio vectorial \(\Lin(\Hil)\) en un espacio de Hilbert sólo es necesario definir un producto escalar hermítico entre dos elementos

Definición: producto escalar

dados dos operadores \(A, B \in \Lin(\Hil)\) definimos su producto escalar \(( A, B)\in {\mathbb C}\)

En una base tenemos que

mientras que

Se sigue que \((B,A) = (A,B)^*\). Además es trivial comprobar que \((A,B+C) = (A,B) + (A,C)\), por lo que se trata de un producto escalar sesquilineal o hermítico.

\(\Lin(\Hil)\) como un espacio normado#

Una norma definida sobre \(\Lin(\Hil) \)es un una función real \( A\to \| A\| \in {\mathbb R}\) con las propiedades que se han definido en una sección anterior

Definición: \(p\)-norma Shatten

Dado un operador \(A\in \Lin(\Hil)\) la función

define una norma, denominada \(p\)-norma de Shatten.

Los tres casos más frecuentes son

\(p=1\) norma de la traza \(~\Rightarrow ~ \| A \|_1 = {\rm tr} \sqrt{A^\dagger A}\)

Esta norma es igual a la suma de los valores singulares de \(A ~\Rightarrow ~\| A \|_1 = \sum_i^r s_i\), donde \(s_i^2\) son los autovalores de \(A^\dagger A\)

\(p=2\) norma de Frobenius \(~\Rightarrow ~ \| A \|_2 = \sqrt{{ \rm tr} A^\dagger A }\)

La norma de Frobenius es la que se obtiene a partir del producto escalar \(\|A\|_2 = (A,A)\)

\(p=\infty\) norma espectral \(~\Rightarrow ~ \| A \|_\infty = \lim_{p\to \infty} \| A \|_p\)

Puede demostrarse que la norma espectral es equivalente a la siguiente definición

Ejercicio

Escribe, en python, una función \(trace\_norm(A)\), que calcule la norma de la traza de un operador.

Distancia de traza#

Cualquier norma permite definir una noción de distancia o diferencia entre dos operadores.

Definición: Distancia de traza

Se define la distancia de traza entre dos operadores \(A\) y \(B\) como la norma de la diferencia

Clases de operadores#

Dentro de \(\Lin(\Hil)\) podemos definir subconjuntos de operadores que mantienen ciertas propiedades importantes. Algunos formarán subespacios vectoriales, y otros no. Podemos definir dichas clases de operadores pidiendo que satisfagan algúna condición o restricción.

Operador Unitario#

Definición:

Un operador unitario \(U\) es tal que su adjunto es igual a su inverso

Naturalmente, esta ecuación se traduce en la misma ecuación para las matrices asociadas en cualquier base

Veamos ahora por qué hemos definido esta clase de operadores.

Teorema:

La acción de un operador unitario conserva intacto el producto escalar de dos vectores cualesquiera.

Demostración

Sea \(U\) un operador unitario, y \(\ket{\varphi'}=U\ket{\varphi}\) y \(\ket{\psi'} = U\ket{\psi}\) dos vectores transformados por \(U\), entonces

particularizando para \(\ket{\varphi} = \ket{\psi}\) tenemos que un operador unitario conserva la norma.

Si conserva el producto escalar \(\Rightarrow\) entonces conserva la norma de cualquier vector \(\Rightarrow\) por tanto, conserva la distancia entre dos vectores \( d (\ket{v},\ket{w})= \| (\ket{v}-\ket{w}) \| \).

Notar

La combinación lineal de operadores unitarios no es unitaria

\(~\) Matemáticamente esto quiere decir que los operadores unitarios no forman un subespacio vectorial de \(\Lin(\Hil)\)

La composición de operadores unitarios es unitaria. Si \(W = UV\) entonces

\(~\) Matemáticamente esto quiere decir que los operadores unitarios forman un grupo: el grupo unitario \(U(N)\) si dim\((\Hil)=N\).

Bases ortonormales#

Como caso particular, aplicando un operador unitario \(U\) a una base ortonormal \(\{\ket{e_i}\}\) obtenemos otra base ortonormal \(\{\ket{\tilde e_i}\}\)

Inversamente, dadas dos bases ortonormales, \(\{\ket{e_i}\}\) y \(\{\ket{\tilde e_i}\}\), el operador que las relaciona es un operador unitario

'definimos una matriz'

U=np.matrix([[1,1J],[1J, + 1]])/np.sqrt(2)

array_to_latex(U)

'getH es un método de la clase matrix que devuelve la matriz conjugada hermítica'

Uadj=U.getH()

array_to_latex(Uadj)

'comprobamos que U es unitaria'

array_to_latex(np.dot(Uadj,U))

Operador Normal#

Definición:

un operador \(N\) es normal si conmuta con su adjunto

Esta propiedad afirma que \(N\) y su adjunto, \(N^\dagger\) conmutan. La siguiente propiedad hace de los operadores normales, objetos muy importantes

Teorema:

\(N\) es un operador normal si y sólo si existe una base ortonormal, \(\{\ket{e_i}\}\), en la cual, la matriz \(N_{ij}\) que lo representa es diagonal

Se podría haber definido un operador normal mediante esta segunda propiedad, y entonces la primera sería un teorema. El caso es que, comprobar si un operador es normal o no, es muy sencillo usando la definición dada.

Operador Hermítico#

Definición:

un operador \(H\) es Hermítico (o autoadjunto) si verifica la ecuación

La matriz asociada a un operador hermítico también se llama hermítica, y coincide con su traspuesta y conjugada

Evidentemente, un operador hermítico conmuta con su adjunto. Por tanto es un caso particular de operador normal.

A partir de cualquier operador \(C\neq C^\dagger \) siempre podemos construir un operador hermítico \(H=H^\dagger\) mediante la combinación lineal

Esto se extiende trivialmente a las matrices que los representan en cualquier base

Notar

La combinación lineal de operadores hermíticos con coeficientes reales es hermítica

Matemáticamente: los operadores autoadjuntos forman un subespacio vectorial real \(\hbox{Her}(\Hil) \subset \Lin(\Hil)\).

La composición de operadores hermíticos, en general no es hermítica

Operador semi-definido positivo#

Definición:

decimos que un operador \(A\) es semi-definido positivo \(A\geq 0\) (o no-negativo) si verifica que

para todo \(\ket{u}\in \Hil\).

Si la desigualdad es estricta \(\bra{u} A\ket{u} > 0 \, ~\forall \ket{u}\), decimos que \(A\) es un operador positivo, \(A>0\).

El siguiente teorema es el equivalente al hecho de que un número real no-negativo \(a\geq 0\) admite una raíz cuadrada real

Teorema:

un operador hermítico \(A=A^\dagger\), es semi-definido positivo \(A\geq 0\) si y sólo si existe otro operador \(B\) tal que

Proyectores#

El operador \(P = \ketbra{u}{u}\) proyecta cualquier vector en la dirección de \(\ket{u}\)

donde \(a = \braket{u}{w}\) es la proyección. De la forma de \(P\) se siguen dos propiedades importantes

es hermítico \(~\Rightarrow~ P^\dagger = (\ketbra{u}{u})^\dagger = \ketbra{u}{u} = P\)

es idempotente \(~\Rightarrow~ P^2 = \ket{u}\braket{u}{u}\!\bra{u} = \ketbra{u}{u} = P \)

De hecho esta dos propiedades bastan para caracterizar un operador como proyector

Definición:

un proyector es un operador hermítico \(P=P^\dagger\) que verifica la ecuación

Notar

El proyector no tiene inverso. Si existiera \(P^{-1}\), multiplicando por él la ecuación \(P^2=P\) llegaríamos a una contradicción \(P = I\).

El proyector es un operador no-unitario: en general, la proyección reduce la norma

donde hemos aplicado la desigualdad de Cauchy Schwarz estricta si suponemos que \(\ket{u}\neq\ket{w}\).

Matriz asociada a un proyector#

Sea \(\{\ket{e_i}\}\) una base ortonormal. El operador \(P_1 = \ketbra{e_1}{e_1}\) proyecta cualquier vector sobre su componente a lo largo de \(\ket{e_1}\).

En forma matricial

de modo que

Si \(\ket{u} = \sum_i u^i\ket{e_i}\) es un vector unitario \(\|\ket{u}\|=1\), entonces el proyector a lo largo de \(\ket{u}\) viene dado por

Es decir, le está asociada una matriz dada por \(P_{ij}=u_iu^*_j\). Es trivial verificar que

como corresponde a un proyector.

Proyector ortogonal#

Sea \(P = \ketbra{u}{u}\) un proyector a lo largo de un vector \(\ket{u}.~\) Entonces el operador \( P_\perp = I - P\) verifica que

es proyector

es perpendicular a \(P\)

la identidad, \(I\) se puede descomponer como

Siempre podemos descomponer cualquier otro vector \(\ket{\psi}\) en sus proyecciones paralela y perpendicular a \(\ket{u}\)

donde \(a = \braket{u}{\psi}\) y \(b = \braket{u_\perp}{\psi}\).

Los tres vectores \(\ket{\psi}, \ket{u}\) y \(\ket{u_\perp}\) están en un mismo hiperplano

d = 3

'generamos un vector aleatorio'

u = tQ.random_ket(d)

#display(array_to_latex(u))

'construimos los proyectores paralelo y perpendicular'

P_par = tQ.ket_bra(u,u);

P_perp = np.identity(d) - P_par

#display(array_to_latex(P_par))

#display(array_to_latex(P_perp))

' verificamos la propiedad P^2 = P, y la ortogonalidad '

A = P_par@P_par - P_par

B = P_perp@P_perp - P_perp

C = P_par@P_perp

#display(array_to_latex(A))

#display(array_to_latex(B))

display(array_to_latex(C))

' obtener las proyecciones paralela y perpendicular de otro vector v'

v = tQ.random_ket(d)

v_par = np.dot(P_par,v)

v_perp = np.dot(P_perp,v)

' verificar perpendicularidad'

print(np.round(tQ.braket(v_par,v_perp),4))

(-0+0j)

Ejercicio (reflector)

Dado un vector unitario \(\ket{u}\), escribe

el operador \(R_u^{\perp}\) que refleja la componente perpendicular a \(\ket{u}\) de cualquier vector \(\ket{\psi}\)

el operador \(R_{u}^{\|}\) que refleja la componente paralela a \(\ket{u}\) de cualquier vector \(\ket{\psi}\)

Proyectores sobre un subespacio#

Consideremos una base ortonormal \(\{\ket{e_i}\}~,i=1,...,N \) de \(\Hil\) y dividámosla en dos subconjuntos

Cualquier vector admite una descomposición ortogonal

con \(\braket{\psi_1}{\psi_2} = 0\).

Decimos que el espacio \(\Hil\) se descompone en la suma directa de subespacios ortogonales

de dimensiones \(N_1 + N_2 = N\),

Los operadores

verifican la ecuación que define un proyector \(P_1^2 = P_1,~P_2^2 = P_2\). Su acción extrae, de un vector dado, la componente sobre el subespacio asociado

Claramente verifican

En resumen, vemos que satisfacen

Notar

proyectar sobre un subespacio no es lo mismo que proyectar a lo largo de un vector. En particular \(P_1 \neq P_v = \ketbra{v}{v}\) donde \(\ket{v} =\frac{1}{\sqrt{N}} \sum_{i=1}^N \ket{e_i}\). El operador \(P_v\) proyectaría cualquier vector en la dirección de \(\ket{v}\). Por ejemplo, con \(N=2\) y \(\ket{v} = \frac{1}{\sqrt{2}}\big(\ket{e_0} + \ket{e_1}\big)\) encontramos

Autovalores y autovectores#

El concepto de autovector y autovalor es esencial para poder definir operaciones de medida en Mecánica Cuántica. Aquí vamos a estudiar lo que son y algunas de sus propiedades esenciales.

Definición: Autovalores y autovectores

Existen vectores, \(\ket{\lambda}\), para los cuales la acción de un operador \(A\) devuelve un vector paralelo

Decimos que \(\ket{\lambda}\) es un autovector (o vector propio) de \(A\) con autovalor (o valor propio) asociado \(\lambda\in {\mathbb C}\)

Ejemplo

Sea \(A\) un operador dado por la matriz siguiente $\( A = \begin{pmatrix} 3 & 2 \\ 1 & 2 \end{pmatrix} \)$ En general, su acción sobre cualquier vector no resultará en un vector paralelo a dicho vector. Pero hay dos vectores para los que esto sí sucede

Operando con estas matrices es elementar mostrar que se verifica

\(\lambda_1 = 4 \) y \(\lambda_2 = -1\) son los autovalores asociados (también denominados valores propio).

Notar

Si $\ket{\lambda}$ es un autovector de $A$, cualquier <b>vector proporcional</b> $\ket{\mu} = a\ket{\lambda}$ también es autovector <b>con el mismo autovalor</b>

Ahora vamos a ver la importancia de trabajar con operadores normales. Según hemos visto, si \(A\) es un operador normal, existe una base ortonormal en la que, la matriz que describe el operador es diagonal. Podemos ver que esta base está formada por todos los autovectores de A.

Efectivamente, denotemos esta base con \(\{\ket{\lambda_i}\}\) y escribamos el operador a partir de su matriz

Entonces, es evidente que \(\ket{\lambda_i}\) son precisamente los autovectores de \(A\)

Supongamos que \(A\) tiene \(d\) vectores propios \(\ket{\lambda_j} = \sum_i v_{ij}\ket{e_i}, \, j=1,..,d\)

Sea \(U_{ij} = v_{ij}\) la matriz formada por las componentes de los vectores propios (apilados por columnas)

Entonces

Si \(A\) es normal, la matriz \(U\), que diagonaliza, es unitaria \(U^{-1} = U^{\dagger}\)

d = 2

' en general una matriz no será normal '

A = np.matrix(np.random.rand(d,d)+ np.random.rand(d,d) * 1j)

display(array_to_latex(np.dot(A,A.getH()) - np.dot(A.getH(),A)))

A = np.matrix([[3,2],[1,2]])

eigvals, eigvecs = np.linalg.eig(A)

print('valprop =',eigvals)

'verificamos que los autovectores son las columnas de v'

m=1 #cambiar a otro valor

display(array_to_latex(np.dot(A, eigvecs[:, m]) - eigvals[m] * eigvecs[:, m],prefix=r'A|\lambda_m \rangle -\lambda_m |\lambda_m\rangle = '))

' diagonalizamos A '

U = np.matrix(eigvecs);

array_to_latex(np.dot(U.getI(),np.dot(A,U)),prefix='A_{diag} = U^{-1} A U = ')

'U no es unitaria'

array_to_latex(np.dot(U,U.getH()))

valprop = [4. 1.]

d = 2

'veamos ahora una matriz normal. En particular podemos tomar la parte hermítica de A'

H = 0.5*(A + A.getH())

'verificamos que es normal'

display(array_to_latex(np.dot(H,H.getH()) - np.dot(H.getH(),H)))

eigvals, eigvecs = np.linalg.eig(H)

print('valprop =',eigvals)

'verificamos que los autovectores son las columnas de v'

m=1 #cambiar a otro valor

display(array_to_latex(np.dot(H, eigvecs[:, m]) - eigvals[m] * eigvecs[:, m],prefix=r'H|\lambda_m \rangle -\lambda_m |\lambda_m\rangle = '))

' diagonalizamos H '

U = np.matrix(eigvecs);

array_to_latex(np.dot(U.getH(),np.dot(H,U)),prefix='H_{diag} = U^{\dagger} H U = ')

'U es unitaria'

array_to_latex(np.dot(U,U.getH()))

valprop = [4.08113883 0.91886117]

Ya hemos visto que la traza de un operador puede calcularse en cualquier base. En particular, podemos usar la base de autoestados en la que la matriz es diagonal. Llegamos a la conclusión de que, siempre que \(A\) sea diagonalizable, la traza de \(A\) será la suma de sus autovalores

Subespacio Propio#

Supongamos que hay \(d\) autovectores linealmente independientes \(\ket{\lambda^{a}}\) con \(a=1,...,d\), que tienen el mismo autovalor. En este caso decimos que \(\lambda\) es \(d\) veces degenerado

Dichos autovectores generan un subespacio propio \(S(\lambda)\subset \Hil\). En efecto, sea \(\ket{u} = \sum_{a=1}^{d} c_a\ket{\lambda^a} \) una combinación de dichos vectores propios, entonces

Por tanto \(\ket{u}\in S(\lambda)\).

El teorema de Gramm-Schmidt garantiza que podemos elegir (mediante un cambio adecuado) el conjunto \(\{\ket{\lambda_{k}}\}\in (\lambda), a=1,...,d\) de forma que que sea una base ortonormal $\(\braket{\lambda^a}{\lambda^b}=\delta_{ab}\)$

El proyector sobre el subespacio propio \(S(\lambda)\) será $\( P_\lambda = \sum_{a=1}^{d} \ketbra{\lambda^a}{\lambda^a} \)$

Ejemplo

Llamemos \(R_z(\theta)\) el operador que efectúa una rotación en el plano \((x,y)\) de ángulo \(\theta\). Cuando \(\theta = \pi\) encontramos las siguiente acción sobre los tres elementos \(\{\hat{\bf x},\hat{\bf y},\hat{\bf z}\}\) de la base cartesiana

Vemos que hay un autovector \(\hat{\bf z}\) con autovalor \(+1\) y dos autovectores \(\hat{\bf x} \) y \(\hat{\bf y} \) con autovalor \(-1\).

El espacio \({\mathbb R}^3\) se divide en dos subespacios propios de \(R_z(\pi)\). Uno de dimensión 1 (a lo largo del eje \(\hat{\bf z}\)) y otro de dimensión 2 (en el plano \((\hat{\bf x},\hat{\bf y})\)).

Los proyectores asociados serán

Espectro de Operadores: casos particulares#

Espectro de Operadores Normales#

Recordemos la definición de un operador normal. \(N\) será un operador normal si conmuta con su adjunto

La importancia de los operadores normales radica en el siguiente lema

Teorema:

los autovectores de un operador normal asociados a dos autovalores distintos son ortogonales

Prueba:

De la ecuación de autovalores \(N\ket{\lambda_j} = \lambda_j \ket{\lambda_j}\), y de \(NN^\dagger = N^\dagger N\), se sigue que

de donde obtenemos \((N^\dagger - \lambda_j^*) \ket{\lambda_j} = 0 \Rightarrow \bra{\lambda_j} N = \bra{\lambda_j}\lambda_j\). Entonces

de donde se sigue que, para \(\lambda_i \neq \lambda_j \Rightarrow \braket{\lambda_i}{\lambda_j} = 0\).

En general, cada autovalor \(\lambda_k\) será \(d_k \geq 1\) veces degenerado. En ese caso hay \(\{\ket{\lambda^a_k}\}, a=1,...,d_k\) autovectores que generan el subespacio propio, \(S(\lambda_k)\subset \Hil \), de dimensión \(d_k\). Subespacios \(S(\lambda_k)\perp S(\lambda_j)\) son ortogonales para \(k\neq j\) según el lema.

En resumen: siempre podemos encontrar una base ortonormal de \(\Hil\), formada por autovectores de un operador normal \(N\). La relación de cierre es

El proyector sobre el subespacio propio \(S(\lambda_k)\) será $\( P_k = \sum_{a=1}^{d_k} \ketbra{\lambda^a_k}{\lambda^a_k} \)$

Espectro de Operadores Hermíticos#

El espectro de un operador hermítico \(A = A^\dagger\), tiene dos propiedades importantes:

los autovalores de un operador hermíticos son reales \(\lambda_i \in {\mathbb R}\).

los autovectores \(\ket{\lambda_i}\) de un operador hermítico asociados a autovalores distintos son ortogonales

Prueba:

Tomemos un autovector normalizado de \(A\), \(\ket{\lambda}\) de autovalor \(\lambda\).

De hecho esta propiedad es cierta para operadores \(N\), normales. Los operadores Hermíticos son normales. De la ecuación de autovalores \(N\ket{\lambda_j} = \lambda_j \ket{\lambda_j}\), y de \(NN^\dagger = N^\dagger N\), se sigue que

de donde obtenemos \((N^\dagger - \lambda_j^*) \ket{\lambda_j} = 0 \Rightarrow \bra{\lambda_j} N = \bra{\lambda_j}\lambda_j\). Entonces

de donde se sigue que, para \(\lambda_i \neq \lambda_j \Rightarrow \braket{\lambda_i}{\lambda_j} = 0\). }

El conjunto de autovectores \(\ket{\lambda_i}\) de un operador hermítico forma una base ortogonal. Puede normalizarse para formar una base ortonormal

Ejercicio

Escribe una función, \(random\_hermitian\), que genere una matriz hermítica de dimensión \(d\).

Comprueba en distintos casos que el espectro es real.

Espectro de Operadores Unitarios#

Los autovalores de un operador unitario son fases puras

Prueba: si \(\{\lambda_i\}\) son autovalores de \(U\), los de \(U^\dagger\) son \(\{\lambda_i^*\}\) y los de \(U^{-1}\) son \(\{\lambda_i^{-1}\}\). La única solución de la ecuación \(\lambda_i^* = \lambda_i^{-1}\) es una fase \(\lambda_i= e^{i\phi_i}\).

Espectro de Proyectores#

Lema:

los autovalores de un proyector sólo pueden ser \(~0~\) ó \(~1~\)

Prueba: la ecuación

sólo tiene dos soluciones consistentes

Espectro de Operadores que Conmutan#

Cuando dos operadores conmutan entre sí, en cierto modo, se comportan como c-número. El siguiente teorema es un reflejo de esto, y tiene una importancia fundamental en la medida completa del estado de un sistema

Teorema:

Dados dos operadores \(A\) y \(B\) que conmutan, existe una base \(\{\ket{\lambda_i}\}\) de autovalores simultáneos de ambos operadores, es decir

Prueba

Supongamos que \(A\) y \(B\) conmutan. Entonces la acción de \(A\) estabiliza los subespacios propios de \(B\).

Es decir, si \(\ket{\lambda}\) es autoestado de \(B\), entonces \(B\ket{\lambda} = \ket{\mu}\) también es autoestado con idéntico autovalor. Se comprueba fácilmente

Por tanto \(\ket{\lambda}\) y \(B\ket{\lambda}\) pertenecen al mismo subespacio propio. Esto es lo que se entiende por estabilizar el subespacio.

Si \(\lambda\) es degenerado esto sólo asegura que \(B\ket{\lambda} = \ket{\lambda'}\) pertenece al subespacio propio del mismo autovalor \(\lambda\).

Esto quiere decir que, dento de cada subespacio propio de \(B\), podemos escoger la base que queramos. En particular podemos escoger una base que diagonalice \(A\) dentro de dicho subespacio.

En otras palabras, dos operadores que conmutan son diagonalizables simultáneamente. Su matriz en la base \(\{\ket{\lambda_i}\}\) es

La importancia de este teorema se manifiesta cuando \(A\) y \(B\) son observables. Supongamos que medimos \(A\) primero y obtenemos \(\lambda_1^A\). El estado obtenido será \(\ket{\lambda_1}\) el cual es, a su vez, autoestado de \(B\). Una medida de \(B\) nos dará \(\lambda_1^B\) sin ambigüedad. y no modificará el estado obtenido, que quedará preparado en un autoestado común de autovalores \((\lambda_1^A, \lambda_2^B)\).

Por tanto, la caracterización más precisa que se puede hacer de un sistema requiere la construcción de un conjunto máximal de observables que conmutan (CMOC). Su obtención es, por tanto de importancia crucial.

Valores Singulares#

Un operador normal está caracterizado unívocamente por su lista de autovalores. Esto es muy útil porque podemos definir la distancia entre dos operadores a partir de la diferencia entre sus listas.

En el caso de un operador general, también podemos definir una colección de números reales que sirven como matrícula del mismo. Son los denominados valores singulares, y también nos servirá para definir la distancia entre dos operadores arbitrarios

Definición:

Se definen los valores singulares de \(A\in \Lin(\Hil)\) como \(s_i =\sqrt{\lambda_i}\) donde \(\lambda_i\) son los autovalores del operador \(A^\dagger A\).

Si \(A\in \Lin(\Hil)\) es un operador general, entonces \(A^\dagger A\) es un operador hermítico que tiene autovalores positivos o cero \(\lambda_i\geq 0\)

Por tanto, podemos tomar su raíz cuadrada \(s_i = \sqrt{\lambda_i} \geq 0\)

Descomposición de Operadores#

Una gran cantidad de resultados relevantes sobre operadores se pueden obtener mediante una descomposición adecuada en productos o sumas de otros operadores con propiedades bien definidas. Vamos a estudiar tres tipos.

Descomposición Espectral#

Teorema: descomposición espectral

Para todo operador normal \(N\) existe una base de autovectores ortonormales, \(\{\ket{\lambda^a_k}\}\), tales que

\(A\) admite la siguiente descomposición espectral

Aquí \(d= {\rm dim}(\Hil)\) y \(P_k = \sum_{a=1}^{g_k} \ketbra{\lambda^a_k}{\lambda^a_k}\) es el proyector sobre el subespacio propio \(S(\lambda_k)\), donde \(\lambda_k\) es \(g_k\) veces degenerado.

La matriz \(A_{ij}\) que expresa \(A\) en la base \(\ket{\lambda_i}\) es diagonal

donde \(\lambda_k\) aparecerá \(d_k\) veces repetido.

'definamos un operador normal'

A = np.array([[1, 1], [-1, 1]])

array_to_latex(A)

' Realizamos la descomposición espectral'

eigvals, eigvecs = np.linalg.eig(A)

eigvec0 = eigvecs[:,0]

P0 = tQ.ket_bra(eigvec0,eigvec0)

display(array_to_latex(P0,prefix='P_0='))

eigvec1 = eigvecs[:,1]

P1 = tQ.ket_bra(eigvec1,eigvec1)

display(array_to_latex(P1,prefix='P_1='))

'verificamos completitud'

array_to_latex(P0+P1,prefix='P_0 + P_1=')

A_descomp_espect = eigvals[0]*P0+eigvals[1]*P1

array_to_latex(A_descomp_espect)

Notar

El operador identidad tiene a cualquier vector por autovector \( I\ket{v} = \ket{v}\), con autovalores \(\lambda_ i = 1\). Por tanto, en cualquier base, la matriz asociada a \(I\) tiene la forma diagonal

La descomposición espectral de \(I\) no es otra que la relación de completitud, que es cierta para cualquier base, ya que todas las bases son bases de autoestados de \(I\)

Ejercicio

Escribe una función \(spectral\_decomp\) en python, que devuelva las dos listas \(\lambda_i\) y \(P_i\) asociadas a la decomposición espectral de un operador diagonalizable \(A = \sum_i \lambda_i P_i\).

Descomposición Polar (PD)#

Teorema: descomposición polar

Todo operador \(A\in \Lin(\Hil)\) admite la descomposición polar \(A = UR\) donde \(U\) es un operador unitario, y \(R\) es un operador semi-definido positivo (sólo tiene autovalores positivos o cero)

La descomposición polar es única y generaliza la representación polar de números complejos \(z = r e^{i\phi}\) a operadores.

El hecho de que \(r\geq 0\) es la contrapartida a que \(R\) sea semi-definida positiva.

El factor \(e^{i\phi}\) es análogo al hecho de que un operador unitario, \(U\), sólo tiene autovalores que son fases puras.

Ejercicio

Escribe una función \(random\_unitary\) que genere una matriz unitaria de dimensión \(d\). Comprueba en distintos casos que el espectro está formado por fases

'''Método para construir una matriz unitaria arbitraria usando la descomposición polar'''

d = 3

A = np.matrix(np.random.rand(d,d)+ np.random.rand(d,d) * 1j)

#u, s, vh = linalg.svd(A, full_matrices=False)

u,r = la.polar(A)

R = np.matrix(r)

' verificamos que R sólo tiene autovalores no-negativos '

Reigval, Reigvec = la.eig(R)

print(np.round(Reigval,3))

U=np.matrix(u)

display(Latex('$$U = %s$$'%MatrixToLatex(U)))

''' Verifiquemos unitariedad '''

display(Latex('$$U^{\dagger}U = %s$$'%MatrixToLatex(np.dot(U.getH(),U))))

''' verificamos que los autovalores de U son fases'''

np.round([la.eig(U)[0][i]*la.eig(U)[0][i].conjugate() for i in range(d)],5)

[2.224+0.j 0.287+0.j 0.773+0.j]

array([1.+0.j, 1.+0.j, 1.+0.j])

Descomposición en Valores Singulares (SVD)#

Vamos a enunciar este teorema para matrices. Concretamente el teorema habla de una matriz \(m\times n\). Este tipo de matrices se corresponden con operadores \(O \in \Lin(\Hil_A,\Hil_B)\) entre espacios de dimensiones \(m\) y \(n\).

Teorema: descomposición en valores singulades SVD

Sea \(A\) una matriz compleja \(m\times n\). Entonces admite la siguiente forma representación factorizada

donde \(U\in U(m)\), \(V\in U(n)\) son matrices unitarias cuadradas de dimensiones \(m\) y \(n\), y \(\,\Sigma \,\) es una matriz rectangular \(m\times n\) con los \(s_1, ...,s_r\) valores singulares no nulos de \(A\) en la diagonal, donde \(r\leq {\rm min}(m,n)\).

Demostración:

Prueba: Tomemos \(m>n\) sin pérdida de generalidad.

Sean \(\ket{\lambda_i}\) los \(n\) autovectores de \(A^\dagger A\in H(n)\), hermítica de dimensión \(n\).

Supongamos que hay \(r\) valores singulares \(s_i = \sqrt{\lambda_i}\) organicémolos en orden decreciente \(\lambda_1\geq \lambda_2\geq ... \geq \lambda_r > 0\) y \(\lambda_{r+1} = ... = \lambda_n = 0\).

Con la base ortonormal \(\ket{\lambda_i}\) podemos formar las siguientes matrices

donde \(\ket{\mu_{r+1}},...\ket{\mu_m}\) completa la base de vectores ortonormales. Ahora podemos operar

donde usamos que \(A\ket{\lambda_i}=0\) para \(i>r\).

'numpy tiene la función svd para descomponer en valores singulares'

A = np.random.randn(3,2)+ 1j*np.random.randn(3,2)

display(array_to_latex(A,prefix='A='))

print( 'the shape of A is :', A.shape)

u, s, vh = la.svd(A, full_matrices=True)

print( 'the shape of u =',u.shape, ' s =', s.shape,' v =', vh.shape)

the shape of A is : (3, 2)

the shape of u = (3, 3) s = (2,) v = (2, 2)

U=np.matrix(u)

S=np.matrix(np.diag(s))

V=np.matrix(vh).getH()

display(array_to_latex(U,prefix='U='))

display(array_to_latex(S,prefix='S='))

display(array_to_latex(V,prefix='V='))

'''Verifiquemos unitariedad'''

display(array_to_latex(np.dot(U.getH(),U),prefix='U^{\dagger}U ='))

display(array_to_latex(np.dot(V.getH(),V),prefix='V^{\dagger}V ='))

Traza#

Traza de un operador#

Definición:

La traza de un operador \(A\) se define como la suma de sus elementos de matriz diagonales en cualquier base

Para ser consistente esta definición es necesario probar que no importa la base utilizada

Lema:

La traza de un operador es independiente de la base en la que se calcule

Prueba

Por esta propiedad, siempre que \(A\) sea diagonalizable en una base \(A\ket{\lambda_j} = \lambda_i \ket{\lambda_i}\), la traza de \(A\) será la suma de sus autovalores

La traza posee dos propiedades importantes

linealidad : $\( {\rm tr} (A + B ) = {\rm tr}A + {\rm tr}B \)$

ciclicidad: la traza es invariante bajo permutaciones cíclicas de los operadores en su argumento. Por ejemplo, para tres operadores \(A, B\) y \(C\)

aniquila conmutadores: para un producto de dos operadores, el anterior resultado implica que la traza de un conmutador es cero. Dicho de otra forma

Notar

sea el operador \(A = \ketbra{u}{v}\) entonces \( \tr \left(\rule{0mm}{5mm}\ketbra{u}{v}\right) = \braket{v}{u}\). Efectivamente $\( \tr \left(\rule{0mm}{5mm}\ketbra{u}{v}\right) = \sum_i \braket{e_i}{u}\braket{v}{e_i} = \sum_i \braket{v}{e_i} \braket{e_i}{u} = \bra{v}\left(\sum_i \ketbra{e_i}{e_i}\right) \ket{u} = \braket{v}{u} \)$

Ejercicio

demuestra la ciclicidad de la traza

\(\Lin(\Hil)\) como un espacio de Hilbert#

Para transformar \(\Lin(\Hil)\) en un espacio de Hilbert sólo es necesario definir un producto escalar hermítico

Definición: producto escalar

Dados dos operadores \(A, B \in \Lin(\Hil)\) definimos su producto escalar \(( A, B)\in {\mathbb C}\)

En una base tenemos que

mientras que

Se sigue que \((B,A) = (A,B)^*\). Además es trivial comprobar que \((A,B+C) = (A,B) + (A,C)\), por lo que se trata de un producto escalar sesquilineal o hermítico.

\(\Lin(\Hil)\) como un espacio normado#

Una norma definida sobre \(\Lin(\Hil) \)es un una función real \( A\to \| A\| \in {\mathbb R}\) con las propiedades que se han definido en una sección anterior

Definición: \(p\)-norma Shatten

Dado un operador \(A\in \Lin(\Hil)\) la función

define una norma, denominada \(p\)-norma de Shatten.

Los tres casos más frecuentes son

\(p=1\) norma de la traza \(~\Rightarrow ~ \| A \|_1 = {\rm tr} \sqrt{A^\dagger A}\)

Esta norma es igual a la suma de los valores singulares de \(A ~\Rightarrow ~\| A \|_1 = \sum_i^r s_i\), donde \(s_i^2\) son los autovalores de \(A^\dagger A\)

\(p=2\) norma de Frobenius \(~\Rightarrow ~ \| A \|_2 = \sqrt{{ \rm tr} A^\dagger A }\)

La norma de Frobenius es la que se obtiene a partir del producto escalar \(\|A\|_2 = (A,A)\)

\(p=\infty\) norma espectral \(~\Rightarrow ~ \| A \|_\infty = \lim_{p\to \infty} \| A \|_p\)

Puede demostrarse que la norma espectral es equivalente a la siguiente definición

Ejercicio

Escribe, en python, una función \(trace\_norm(A)\), que calcule la norma de la traza de un operador.

Distancia de traza#

Cualquier norma permite definir una noción de distancia o diferencia entre dos operadores.

Definición: Distancia de traza

Se define la distancia de traza entre dos operadores \(A\) y \(B\) como la norma de la traza de la diferencia

Funciones de Operadores#

Funciones analíticas#

Estamos acostumbrados a escribir funciones de una variable real o compleja. Por ejemplo \(f(x)= x^2\), ó, \( f(z) = e^z\).

Querríamos dar sentido a la función de un operador \( A \to f(A) \)

En el caso de que \(f(z)\) sea una función analítica expresable como una serie de Taylor en torno a \(x=0\)

tomaremos como definición la misma serie cambiando el argumento \(x\to A\)

Notar

no estamos exigiendo nada a \(A\) para que definir \(f(A)\) de esta manera

de la misma forma que, para funciones analíticas \(f(z)^* = f(z^*)\), también la definición anterior asegura que \(f(A)^\dagger = f(A^\dagger)\)

Exponencial de un operador#

Un caso de uso frecuente es la exponencial de un operador

d = 2

A = 0.2*np.matrix(np.random.rand(d,d)+ np.random.rand(d,d) * 1j)

' exponencial '

array_to_latex(expm(A),prefix='e^A = ')

display(array_to_latex(expm(A),prefix='e^A = '))

' serie truncada a orden cuadrático'

Id = np.matrix(np.identity(d))

power_series = Id + A + 1./2*A*A

display(array_to_latex(power_series,prefix= r'I + A + \frac{1}{2}A^2 = '))

---------------------------------------------------------------------------

NameError Traceback (most recent call last)

Cell In[16], line 5

2 A = 0.2*np.matrix(np.random.rand(d,d)+ np.random.rand(d,d) * 1j)

4 ' exponencial '

----> 5 array_to_latex(expm(A),prefix='e^A = ')

7 display(array_to_latex(expm(A),prefix='e^A = '))

9 ' serie truncada a orden cuadrático'

NameError: name 'expm' is not defined

Fórmula de Baker-Campbel-Haussdorf#

Una propiedad importante de la función exponencial es \(e^xe^y = e^{x+y}\). La propiedad análoga para operadores sólo es cierta cuando conmutan entre sí. Para el caso genérico tenemos dos opciones

Teorema: Baker-Campbel-Haussdorf

Sean \(A,B\subset{\rm L}(\Hil)\) dos operadores lineales genéricos. Entonces

Vemos que

Si \(A\) y \(B\) conmutan,

Si el conmutador de \(A\) y \(B\) es un c-número

El inverso de \(e^A\) es \(e^{-A}\). Efectivamente, como

En el caso general, \(A\) y \(B\) no conmutarán, \([A,B]\neq 0\) y se generará una serie infinita de términos. Sin embargo hay una fórmula que permite factorizar la exponencial de una suma, en forma de un productorio infinito de operadores infinitesimales \(A/n\) y \(B/n\)

Teorema: Lie-Suzuki-Trotter

Sean \(A,B\subset{\rm L}(\Hil)\) dos operadores lineales genéricos. Entonces

Esta expresión es la base de la simulación cuántica en circuitos cuánticos digitales

Teorema:

Sea \(A\) un operdor que verifique \(A^2 = I\), demuestra que se cumple la generalización de la ecuación de Euler

Ejercicio

Demuestra el teorema anterior

Operadores unitarios a partir de hermíticos#

Teorema:

todo operador unitario \(U\) se puede expresar como la exponencial imaginaria de un operador hermítico \(H\)

Efectivamente,

por tanto, \(U\) es unitario si y sólo si \(H\) es hermítico.

Prueba

Funciones generales#

No siempre \(f(z)\) es analítica en torno a \(z=0\). Es el caso, por ejemplo, de \(f(z) = \exp(1/z)\), o de \(f(z) = \log z\). Por tanto, esta función no admite una expansión en serie de Taylor.

Aun así, si la función \(f(z)\) existe, y \(A\) es un operador normal, el operador \(f(A)\) también existe. Para construirlo es necesario recurrir a la forma diagonalizada

Teorema:

Sea \(A\) un operador diagonalizable, y sea \(A= \sum_i \lambda_i \ket{\lambda_i}\bra{\lambda_i}\) su representación espectral. Entonces el operador \(f(A)\) tiene la representación espectral siguiente

En otras palabras, si la matriz \(A^{(D)}_{ij} = \lambda_i \delta_{ij} \) es diagonal, cualquier función de la misma es, trivialmente, la matriz diagonal que se obtiene evaluando \(f(\lambda_i)\)

Ejemplo 1

Ejemplo 2

Ahora podemos invertir la expresión que permite construir un operador unitario a partir de otro hermítico

Matrices de Pauli#

Las matrices hermíticas forman un subespacio vectorial \(\hbox{Her}(\Hil)\subset \Lin(\Hil)\) que admite una base de matrices hermíticas

Definición:

Se definen las matrices de Pauli

Notar

De forma colectiva, usaremos \(\sigma_i\) donde \(\sigma_1=\sigma_x, ~ \sigma_2=\sigma_y\) y \(\sigma_3=\sigma_z\). También \(\boldsig\) denota el vector de matrices de Pauli \(\boldsig = (\sigma_1,\sigma_2,\sigma_3)\).

Si añadimos la matriz identidad \(~I = \begin{bmatrix} 1 & 0 \\ 0 & 1 \end{bmatrix}~ \) el conjunto \(\{I,\sigma_x,\sigma_y,\sigma_z\}\) forma una base para el espacio de matrices hermíticas \(2\times 2\)

con \(a_i\in {\mathbb R}\) cuatro números reales

En total, las matrices de Pauli poseen tres propiedades que las hacen únicas

son hermíticas \(\sigma_i^\dagger = \sigma_i\)

son unitarias \(\sigma_i^\dagger = \sigma_i^{-1} = \sigma_i\)

tienen traza nula \(\tr(\sigma_i) = 0\)

Composición#

La composición de dos matrices de Pauli es otra matriz de Pauli que cumple la siguiente identidad

donde

Ejemplos:

s0 = np.matrix([[1,0],[0,1]])

s1 = np.matrix([[0,1],[1,0]])

s2 = np.matrix([[0,-1j],[1j,0]])

s3 = np.matrix([[1,0],[0,-1]])

'verifica todas las opciones'

print(s1*s1==s0)

print(s1*s2==1j*s3)

print(s2*s1==-1j*s3)

print(s2*s1*s2==-s1)

print(s1*s1==s0)

[[ True True]

[ True True]]

[[ True True]

[ True True]]

[[ True True]

[ True True]]

[[ True True]

[ True True]]

[[ True True]

[ True True]]

Nota

De las relaciones de composición anteriores se siguen inmediatamente las siguientes reglas de (anti) conmutación

Las matrices de Pauli tienen traza nula $\( {\rm tr} \, \sigma_i = 0 \)$

Tomando la traza de la relación de composición obtenemos que las matrices de Pauli son ortogonales en el sentido siguiente

Exponenciación#

Consideremos la matriz hermítica siguiente

con \(a_i\in {\mathbb R}\) tres números reales. Separemos \({\bf a}\) en su módulo, \(a\), y su dirección \(\hat{\bf n}\)

donde \(a=|{\bf a}|=\sqrt{a_1^2+a_2^3+a_3^2}~\) y \(\hat{\bf n}\) es unitario. Entonces

Queremos hallar la exponencial \(e^{i {\bf a} \cdot \boldsymbol{\sigma}}\).

Teorema:

Ejercicio

Demuestra que \((\hat{\bf n} \cdot \boldsymbol{\sigma})^2 = I\). Esto convierte este resultado en un corolario de un teorema anteriormente demostrado.

Demuestra el teorema a partir de la descomposición espectral de las tres matrices de Pauli, \(\sigma_x, \sigma_y \) y \(\sigma_z\).

' vamos a verificar numéricamente'

from scipy.linalg import expm

' vectors a and sigma'

avec = np.random.rand(3)

sigvec = np.array([s1,s2,s3])

'exponentiating'

adots= sum(list(avec[i]*sigvec[i] for i in range(3)))

e1 = expm(1j*adots)

'using the Euler-like formula'

a = np.linalg.norm(avec)

nvec = avec/a

ndots= sum(list(nvec[i]*sigvec[i] for i in range(3)))

e2 = np.cos(a)*s0 + 1j*np.sin(a)*(nvec[0]*sigvec[0]+nvec[1]*sigvec[1]+nvec[2]*sigvec[2])

'verify'

display(array_to_latex(e1,prefix='exp(s1)='))

display(array_to_latex(e2,prefix='exp(s1)='))